حين يقلق الناس بشأن الذكاء الاصطناعي، لا يقتصر سبب ذلك على ما سيجلبه مستقبلاً بل إنهم يستحضرون ما كان في الماضي أيضاً، بالأخص التأثير السيئ لوسائل التواصل الاجتماعي. فقد تخطى خطاب الكراهية ومعه المعلومات المضللة، عتبات ضبط المحتوى لدى "فيسبوك" و"تويتر" لسنوات وانتشر حول العالم.

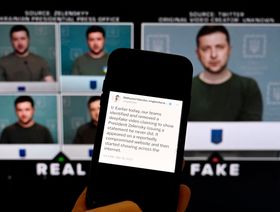

اليوم، تغزو صور ومقاطع فيديو معدّة بتقنية التزييف العميق المنصات نفسها. وفيما تستمر مسؤولية "فيسبوك" عن كيفية انتشار ما يسيء عبر منصتها، يتوجّب على شركات الذكاء الاصطناعي التي تصنع هذه التقنيات أن تلعب دورها في التصدّي لمثل هذا المحتوى. لكن للأسف، كما كان حال شركات التواصل الاجتماعي من قبل، تعمل شركات الذكاء الاصطناعي على هذه المسألة بتكتم.

تواصلت مع نحو 10 من شركات الذكاء الاصطناعي التوليدي، التي تقدم أدوات قادرة على إنتاج صور ومقاطع فيديو ونصوص وأصوات مزيفة يصعب تمييزها عن ما هو حقيقي، لأسأل عن طريقة تحققها من التزام مستخدميها بقواعدها.

أجابت جميعها أنها استخدمت برامج إلكترونية لمراقبة ما ينتجه المستخدمون، فيما قالت أغلبها إنها كلفت عناصر بشرية للتحقق من تلك الأنظمة أيضاً، لكن لم توافق أي من الشركات تقريباً على كشف عدد المكلفين بالإشراف على هذه الأنظمة.

اقرأ أيضاً: احتيال بتقنية التزييف العميق يكلف شركة عالمية 26 مليون دولار

غياب التنظيم القانوني

لكن هل يتوجب على هذه الشركات أن تفصح عن مثل هذه المعلومات أصلاً؟ على عكس قطاعات الدواء والغذاء وصناعة المركبات، فإن شركات الذكاء الاصطناعي ليست ملزمة قانوناً بكشف التفاصيل المتعلقة بإجراءات الأمان لديها. كما هو حال شركات التواصل الاجتماعي، يمكن لشركات الذكاء الاصطناعي أن تحافظ على سرية عملها قدر ما تشاء، وسيستمر هذا الوضع على الأرجح في السنوات المقبلة.

وفي حين أن القانون المتعلق بالذكاء الاصطناعي الذي أعدّه الاتحاد الأوروبي تناول "متطلبات الشفافية"، لم يتضح بعد إن كان هذا القانون سيُخضع ممارسات الأمان في شركات الذكاء الاصطناعي إلى نوع التدقيق نفسه الذي تخضع له شركات صناعة السيارات والأغذية.

استغرقت تلك القطاعات عقوداً لتبنّي معايير سلامة صارمة، لكن العالم لا يستطيع تحمل تبعات تصرف أدوات الذكاء الاصطناعي بحرية مطلقة للفترة ذاته في ظل تطورها بالغ السرعة.

حدثت شركة "ميدجورني" (Midjourney) برنامجها الإلكتروني أخيراً ليصبح قادراً على توليد صور واقعية جداً لدرجة تُظهر حتى المسام والخطوط الدقيقة في بشرة بعض السياسيين.

ومع بداية عام انتخابي بامتياز، سيتوجه خلاله نحو نصف سكان العالم إلى صناديق الاقتراع، فإن الفراغ التنظيمي يعني أن المحتوى المولّد بالذكاء الاصطناعي قد يكون له وقع مدمّر على الديمقراطية وحقوق النساء والفنون الإبداعية وغيرها الكثير.

ثمّة طرق لمعالجة هذه المشكلة، منها الضغط على شركات الذكاء الاصطناعي لتلتزم أكثر بمعايير الشفافية على صعيد إجراءات الأمان المتبعة، ويبدأ ذلك بطرح الأسئلة عليها. فحين تواصلت مع "أوبن إيه أي" و"مايكروسوفت" و"ميدجورني"، حرصت على أن تكون أسئلتي بسيطة، مثل: كيف تفرضون تطبيق قواعدكم بواسطة البرامج الإلكترونية والعنصر البشري، وكم عدد الناس المكلفين بهذا العمل؟

اقرأ أيضاً: انتحال الشخصية بـ"التزييف العميق" يقود موجة جديدة من جرائم الاحتيال

دور العنصر البشري

كانت أغلب الشركات مستعدة لتزويدي بعدة فقرات تتضمن تفاصيل حول الإجراءات التي تعتمدها لمنع إساءة الاستخدام (وقد أتت صياغتها مبهمة كما نصوص العلاقات العامة). لدى "أوبن إيه أي" على سبيل المثال فريقان يساعدان على إعادة تدريب نماذج الذكاء الاصطناعي لزيادة الأمان أو القدرة على كشف الإنتاج المؤذي.

من جانبها، قالت الشركة التي تقف خلف برنامج توليد الصور المثير للجدل "ستيبل ديفيوجن" (Stable Diffusion) إنها استخدمت "فلاتر" لتحظر الصور التي تخالف قوعدها، وأن مراقبين بشريين تحققوا مما أشير إليه من مدخلات وصور تمّ التنبيه عليها.

لكن لم تكشف إلا شركات قليلة عن عدد البشر الذين استخدمتهم للإشراف على أنظمتها. وظيفة أولئك أشبه بمفتشي السلامة، وفي وسائل التواصل الاجتماعي يُسمون مشرفي المحتوى ويلعبون دوراً صعباً ولكن أساسياً في مراجعة المحتوى الذي تنبّه خوارزميات وسائل التواصل الاجتماعي على أنه عنصري مثلاً أو مسيء للنساء أو عنيف.

تضمّ "فيسبوك" أكثر من 15 ألف مشرف محتوى يعملون على الحفاظ على نزاهة الموقع من دون الوقوع في تضييق حريات المستخدمين، فالبشر هم الأقدر على الحفاظ على مثل هذا التوازن الدقيق.

صحيح أنه نظراً للفلاتر التي تتضمّنها معظم أدوات الذكاء الاصطناعي، فهي لا تنتج محتويات مسيئة بقدر البشر على "فيسبوك"، مع ذلك فإن هذه الأدوات قابلة لأن تكون أكثر أماناً وموثوقيةً إذا ما وظفت الشركات مزيداً من المشرفين. فالبشر هم أفضل من يتصدّى للمحتوى المسيء في غياب برامج إلكترونية أفضل، بما أن الموجودة أثبتت قصورها حتى الآن.

زيادة التوظيف

يظهر انتشار مقاطع إباحية للنجمة تايلر سويفت معدّة بتقنية التزييف العميق، وتسجيلات تستسخ صوت الرئيس جو بايدن وغيره من السياسيين الدوليين، من بين أمور أخرى، أن شركات الذكاء الاصطناعي وشركات التقنية لا تستثمر ما يكفي في إجراءات الأمان.

مع ذلك، لا بدّ من الاعتراف أن توظيف مزيد من الناس لمساعدة الشركات على تطبيق قواعدها أشبه برمي دلاء من الماء على منزل شبت به النيران، فذلك لن يحلّ المشكلة، لكنه قد يحسن الوضع مؤقتاً.

اقرأ أيضاً: بعد انتشار صور تايلور سويفت.. ماذا تعرف عن "التزييف العميق"؟

قال بن ويتيلو، مؤسس نشرة (Everything in Moderation) الإخبارية، التي تتناول الأمان على الإنترنت: "إذا كنت شركة ناشئة تبني منتج ذكاء اصطناعي توليدي، فإن توظيف عناصر بشرية في مراحل مختلفة من التطوير إجراء حكيم جداً، لا بل أساسي".

أقرّت عدة شركات ذكاء اصطناعي أنه ليس لديها سوى مشرف أو اثنين من العناصر البشرية. وقالت شركة "رانواي" (Runway) لتوليد مقاطع الفيديو، إن الباحثين العاملين لديها يتولون هذا العمل، فيما قالت شركة "ديسكريبت" (Descript) التي تصنع أداة لاستنساخ الأصوات تحمل اسم (Overdub) إنها لم تتحقق إلا من عينة من الأصوات المستنسخة لضمان أنها تتطابق مع إقرار بالموافقة يتلوها المستخدمون بأصواتهم. وبررت المتحدثة باسم الشركة ذلك بالقول إن التحقق من أعمال المستخدمين ينتهك خصوصيتهم.

تتمتع شركات الذكاء الاصطناعي بحرية لا نظير لها للحفاظ على سرية عملها. ولكن إذا كانت تسعى لثقة الجمهور والهيئات الناظمة والمجتمع المدني، فمن مصلحتها إزاحة الستار عن طريقة عملها لتظهر للعالم كيفية تطبيق قواعدها. كما أن توظيف مزيد من الناس ليس فكرةً سيئةً بحدّ ذاتها.

تهدد المبالغة بالتركيز على السباق لجعل الذكاء الاصطناعي "أذكى"، لتبدو الصور المزيفة حقيقية أكثر والنصّ أكثر سلاسة واستنساخ الأصوات أكثر إتقاناً، بجرّنا نحو عالم من المخاطر والإرباك. الإجراء الأجدى هو زيادة التوظيف الآن للكشف عن معايير الأمان قبل أن يصبح كل شيء أصعب.