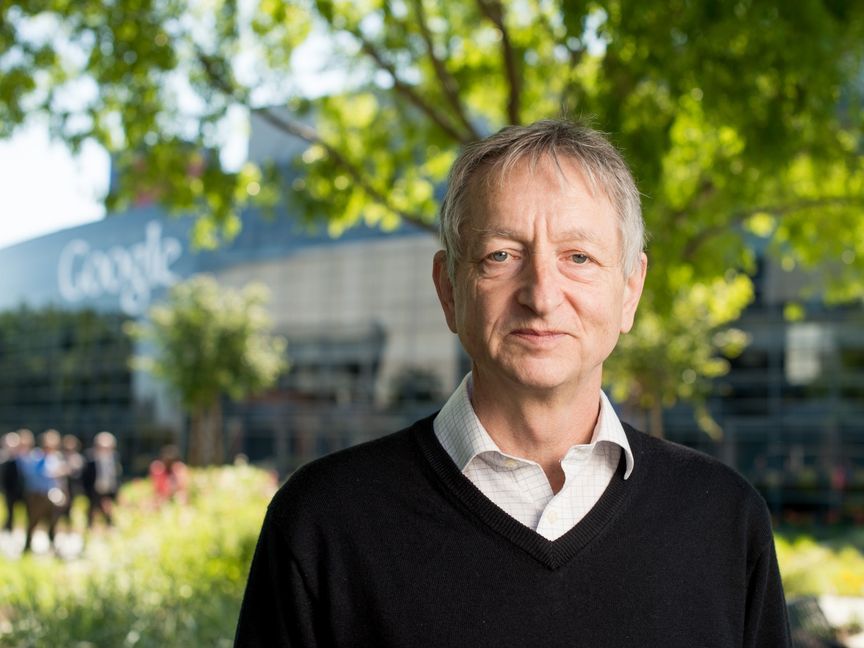

يصعُب أن لا يثير القلق قول جيفري هينتون، الملقب بالأب الروحي للذكاء الاصطناعي، إنه سيستقيل من شركة "غوغل"، وإنه نادم على الأعمال التي قدمها في حياته.

هينتون، الذي قدم مساهمة مهمة في أبحاث الذكاء الاصطناعي في السبعينيات من خلال عمله على الشبكات العصبية، صرح للعديد من الوسائل الإخبارية هذا الأسبوع أن شركات التكنولوجيا الكبيرة تحركت بسرعة أكثر من اللازم تجاه نشر الذكاء الاصطناعي للجمهور. وكان أحد جوانب المشكلة هو أن الذكاء الاصطناعي يقدم مهارات شبيهة بالإنسان بسرعة أكبر مما توقعه الخبراء. ووصف الأمر في حواره مع صحيفة "نيويورك تايمز بقوله: "هذا مخيف".

المؤكد أن مخاوف هينتون منطقية، لكنها كانت ستصبح أكثر فاعلية بكثير لو كان صرح بها قبل عدة سنوات، عندما كان باحثون آخرون يحذرون من الأمر نفسه وهم ما يزالون في مقتبل مسيرتهم المهنية، وليس قبل تقاعدهم مباشرة مثلما فعل.

الخوف من شركات التكنولوجيا

اللافت للنظر، أن هينتون نشر تغريدة لتفسير الطريقة التي وصفت بها صحيفة "نيويورك تايمز" دوافعه، وذلك خوفاً من إشارة المقال إلى أنه ترك "غوغل" حتى يتمكن بحرية من انتقادها. وكتب: "في الواقع، لقد غادرت حتى أتمكن من التحدث عن مخاطر الذكاء الاصطناعي عموماً، دون التفكير في مدى تأثير ذلك على (غوغل). لكن (غوغل) تصرفت بمسؤولية كبيرة".

رغم أن الهالة التي أحاطت بهينتون في هذا المجال ربما تكون قد أبعدته عن سماع ردود الفعل السلبية، إلا أن تصريحاته تسلط الضوء على مشكلة مزمنة في أبحاث الذكاء الاصطناعي، وهي أن شركات التكنولوجيا الكبرى تحكم قبضتها على هذه الأبحاث، لدرجة أن العديد من علمائها يخشون التعبير عن مخاوفهم خوفاً من الإضرار بمسيرتهم المهنية مستقبلاً.

يمكن فهم الأسباب الكامنة وراء ذلك الخوف، حيث اضطرت ميريديث ويتاكر، مديرة الأبحاث السابقة في "غوغل"، إلى إنفاق آلاف الدولارات على المحامين في 2018 بعدما ساعدت على تنظيم مظاهرة لـعشرين ألفاً من موظفي الشركة، اعتراضاً على تعاقداتها مع وزارة الدفاع الأميركية. وصرحت لي بقولها: "الوقوف أمام (غوغل) مخيف حقاً". وفي نهاية المطاف استقالت من شركة محركات البحث العملاقة، بعد تحذيرها من التحدث عن توجهات الشركة في العلن، وتشغل الآن منصب الرئيس التنفيذي لتطبيق الرسائل المشفرة "سيغنال" (Signal).

بعد ذلك بعامين، طُرد تيمنت غيبرو ومارغريت ميتشل باحثا الذكاء الاصطناعي في "غوغل" من شركة التكنولوجيا العملاقة، بعدما أصدرا بحثاً سلط الضوء على مخاطر نماذج اللغة الكبيرة، وهي التقنية التي يدور حولها الآن العديد من المخاوف بشأن برامج الدردشة والذكاء الاصطناعي التوليدي. وأشارا إلى معاناتها من ثغرات مثل التحيز العنصري والجنساني، والغموض والمخاطر البيئية.

أبطال مجهولون

تشعر ويتاكر بامتعاض من فكرة تصدر صور هينتون الآن لوسائل الإعلام التي تتحدث عن مساهماته الجليلة في مجال الذكاء الاصطناعي، بينما هناك آخرون خاطروا أكثر منه بكثير للدفاع عما يؤمنون به فعلاً أثناء عملهم في "غوغل".

وتقول إن "الأشخاص الذين يتمتعون بسلطة أقل بكثير ومناصب أكثر تهميشاً هم الأبطال الحقيقيون الذين يحملون على عاتقهم مخاطر شخصية كبيرة حتى يعرف الناس المشكلات المتعلقة بالذكاء الاصطناعي والشركات التي تتحكم فيه".

رفض هينتون الإجابة عن سؤال حول السبب وراء عدم تحدثه عن تلك المخاطر في وقت سابق. لكن يبدو أنه كان قلقاً بشأن الذكاء الاصطناعي لبعض الوقت الآن، بما في ذلك في السنوات التي كان زملاؤه حريصون فيها على اتباع نهج أكثر حذراً تجاه التكنولوجيا.

جاذبية الاختراعات المدمرة

أوضح مقال نُشر في مجلة "نيويوركر" عام 2015 أنه تحدث مع باحث آخر في الذكاء الاصطناعي عن كيفية استخدام السياسيين للذكاء الاصطناعي في إرهاب الناس، وكان ذلك على هامش أحد المؤتمرات. وعندما سُئل عن سبب استمراره في إجراء أبحاث بهذا المجال، أجاب هينتون: "يمكنني أن أقدم لكم الحجج المعتادة، لكن الحقيقة هي أن اكتشاف أشياء جديدة في هذا المجال ممتع جداً". ويشبه هذا التصريح إلى حد كبير الوصف الشهير الذي استخدمه ج. روبرت أوبنهايمر للحديث عن "انجذابه بشكل ممتع من الناحية التقنية للعمل على القنبلة الذرية".

يقول هينتون إن "غوغل" تصرفت "بمسؤولية كبيرة" في نشرها للذكاء الاصطناعي. لكن هذا جزء من الحقيقة فقط. نعم، أغلقت الشركة أعمالها في مجال التعرف على الوجه بسبب مخاوف من إساءة الاستخدام، كما أنها استمرت في العمل على نموذج اللغة المتطور "لا إم دي إيه" (LaMDA) دون الكشف عنه لمدة عامين من أجل العمل على جعله أكثر أماناً وأقل تحيزاً. كما قيدت غوغل" إمكانات الروبوت "بارد"، وهو النظير التقني الذي قدمته الشركة لمنافسة تطبيق "تشات جي بي تي".

لكن كونك مسؤولاً يعني أيضاً أن تكون شفافاً وخاضعاً للمساءلة، وتاريخ "غوغل" في قمع مخاوف العاملين فيها بشأن تقنياتها لا يبعث على الثقة.

نأمل أن يؤدي رحيل هينتون وتحذيراته إلى إلهام باحثين آخرين في شركات التكنولوجيا الكبرى للتحدث عن مخاوفهم.

احتجاز العقول

حبست بعض التكتلات التكنولوجية الكبيرة مجموعة من ألمع العقول في الأوساط الأكاديمية بين جدرانها، بعدما أغرتهم بالرواتب المرتفعة والمزايا الوظيفية السخية وقوة الحوسبة الضخمة المستخدمة في التدريب والتجربة على نماذج ذكاء اصطناعي أصبحت قوية للغاية.

مع ذلك، هناك علامات على أن بعض الباحثين يفكرون على الأقل في أن يكونوا أكثر صراحة بشأن مخاوفهم. قالت كاثرين أولسون، وهي موظفة في القسم التقني بشركة "أنثروبيك" لتقنيات التأمين والسلامة المعتمدة على الذكاء الاصطناعي الاثنين الماضي، رداً على تعليقات هينتون: "أفكر كثيراً في الموعد الذي سأترك فيه العمل بهذه الشركة الناشئة المتخصصة في الذكاء الاصطناعي، أو أترك العمل بمجال الذكاء الاصطناعي تماماً". يمكنني القول بالفعل إن هذه الخطوة ستؤثر علي".

يبدو أن العديد من باحثي الذكاء الاصطناعي يتقبلون فكرة أنه لا يمكن فعل الكثير لوقف تيار الذكاء الاصطناعي التوليدي، بعدما أُطلق للعالم. حسب تصريح جاريد كابلان، المؤسس المشارك لشركة "أنثروبيك" (Anthropic) في مقابلة نُشرت الثلاثاء الماضي، مضيفاً: "الأمور خرجت عن السيطرة".

لكن إذا كان الباحثون الذين ما يزالون يعملون على استعداد للتحدث الآن بينما ما يزال بوسعنا التصرف -وليس قبل تقاعدهم مباشرة- فعلى الأرجح سيصب ذلك في مصلحتنا جميعاً.